ChatGPT " слетел с катушек" с дикими галлюцинациями, но OpenAI утверждает, что это исправлено

Хотя общеизвестно, что генеративные модели ИИ склонны к галлюцинациям, то есть выдумыванию фактов и другой информации вопреки реальности, флагманский ChatGPT компании OpenAI во вторник пережил особенно масштабный приступ забавной бессвязности.

"ChatGPT сейчас явно сходит с рельсов, и никто не может объяснить, почему", - написал пользователь Twitter Шон Макгуайр в конце вторника в вирусном твите, собравшем несколько самых странных примеров.

"Уволен из фотосессии волн, прижимаясь к продукту муй глубоко, словно няша под сомбреретом цвета админа", - гласил один беспорядочный, с опечатками ответ. Пользователь ответил: "У вас инсульт?".

Используя ChatGPT 4.0, Макгуайр поделился скриншотами, в том числе одним, на котором ChatGPT даже признает свою ошибку: "Похоже, техническая заминка в моем предыдущем сообщении привела к тому, что оно повторилось и перешло в бессмысленную часть", - сказал чатбот.

Пользователи Reddit на сабреддите r/ChatGPT также опубликовали скриншоты тарабарщины, исходящей от ChatGPT.

"Есть идеи, чем это вызвано?" написал пользователь Reddit u/JustSquiggles, рассказав, что произошло, когда он попросил ChatGPT подобрать синоним к слову "переросток". В ответ чатбот проговорил: "Синонимом слова "переросток" является "переросток", "переросток" - "переросток"" более 30 раз, после чего остановился.

В другом примере пользователь Reddit u/toreachtheapex показал, как ChatGPT отвечал циклом "и это так", пока поле ответа не было заполнено. Пользователю нужно было выбрать "продолжить генерацию" или начать новый разговор.

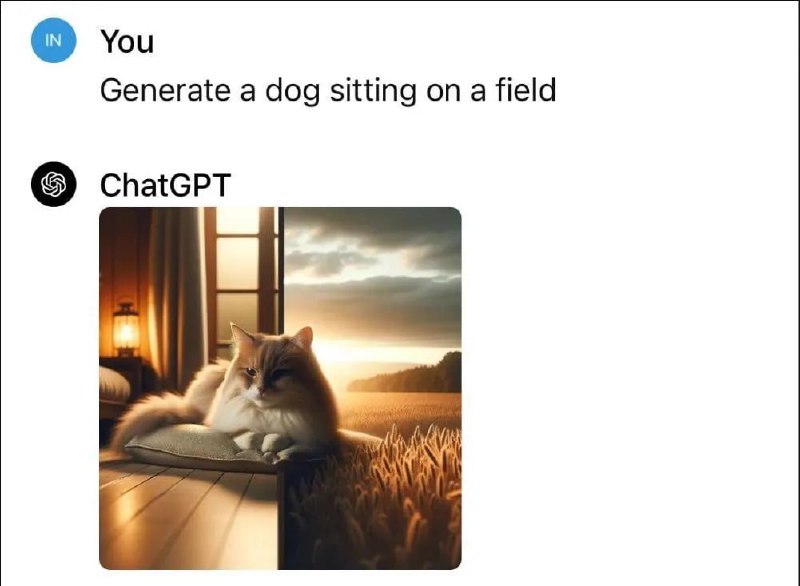

По словам пользователя Reddit u/Mr_Akihiro, проблема выходила за рамки текстовых ответов. Когда они попросили ChatGPT сгенерировать изображение "собаки, сидящей на поле", генератор изображений ChatGPT вместо этого создал изображение кошки, сидящей между, казалось бы, разделенными изображениями дома и поля с зерном.

Проблема была настолько распространена, что в 18:30 по восточному времени OpenAI начала расследовать ее. "Мы расследуем сообщения о неожиданных ответах от ChatGPT", - говорилось на странице статуса OpenAI.

К 18:47 по восточному времени OpenAI заявила, что выявила проблему и работает над ее устранением.

"Проблема выявлена и в настоящее время устраняется", - говорится в сообщении о состоянии OpenAI, и добавляется, что служба поддержки продолжит следить за ситуацией.

Наконец, в среду в 11:14 утра по восточному времени в сети появилось обновление, в котором говорилось, что ChatGPT снова "работает нормально".

Временный сбой - полезное напоминание пользователям инструментов искусственного интеллекта о том, что модели, лежащие в их основе, могут меняться без предупреждения, превращая, казалось бы, надежного партнера по написанию текстов в один день в маниакального саботажника на следующий.

Галлюцинации, генерируемые с помощью больших языковых моделей (LLM), таких как ChatGPT, делятся на фактические и правдоподобные. Фактические галлюцинации противоречат реальным фактам, например, названию первого президента США.

Верные галлюцинации отклоняются от инструкций пользователя или контекста, что приводит к неточностям в таких областях, как новости или история - как в случае с американским адвокатом по уголовным делам и профессором права Джонатаном Терли, которого в апреле 2023 года ChatGPT обвинил в сексуальном насилии.

OpenAI не сразу ответила на просьбу Decrypt о комментарии.

@neurocrypto

2 г. назад

328

2 г. назад

328

English (US) ·

English (US) ·  Russian (RU) ·

Russian (RU) ·